Em um evento realizado em 13 de maio de 2024, a OpenAI deu as boas-vindas ao seu novo modelo de IA aprimorado: o GPT-4o.

“Estamos anunciando o GPT-4o, nosso novo modelo principal que pode raciocinar através de áudio, visão e texto em tempo real.”

Confira todas as novidades sobre o novo modelo e como utilizá-lo:

O GPT-4o

O GPT-4o (que, segundo a startup, é “o de ‘omni’”), é um grande salto em relação ao GPT-4 e ao ChatGPT que conhecemos hoje.

Com o lançamento, a OpenAI apresenta uma nova forma de interação entre “humano-computador”, tornando a comunicação mais natural e precisa, como uma verdadeira conversa entre duas pessoas.

Say hello to GPT-4o, our new flagship model which can reason across audio, vision, and text in real time: https://t.co/MYHZB79UqN

Text and image input rolling out today in API and ChatGPT with voice and video in the coming weeks. pic.twitter.com/uuthKZyzYx

— OpenAI (@OpenAI) May 13, 2024

Segundo a startup:

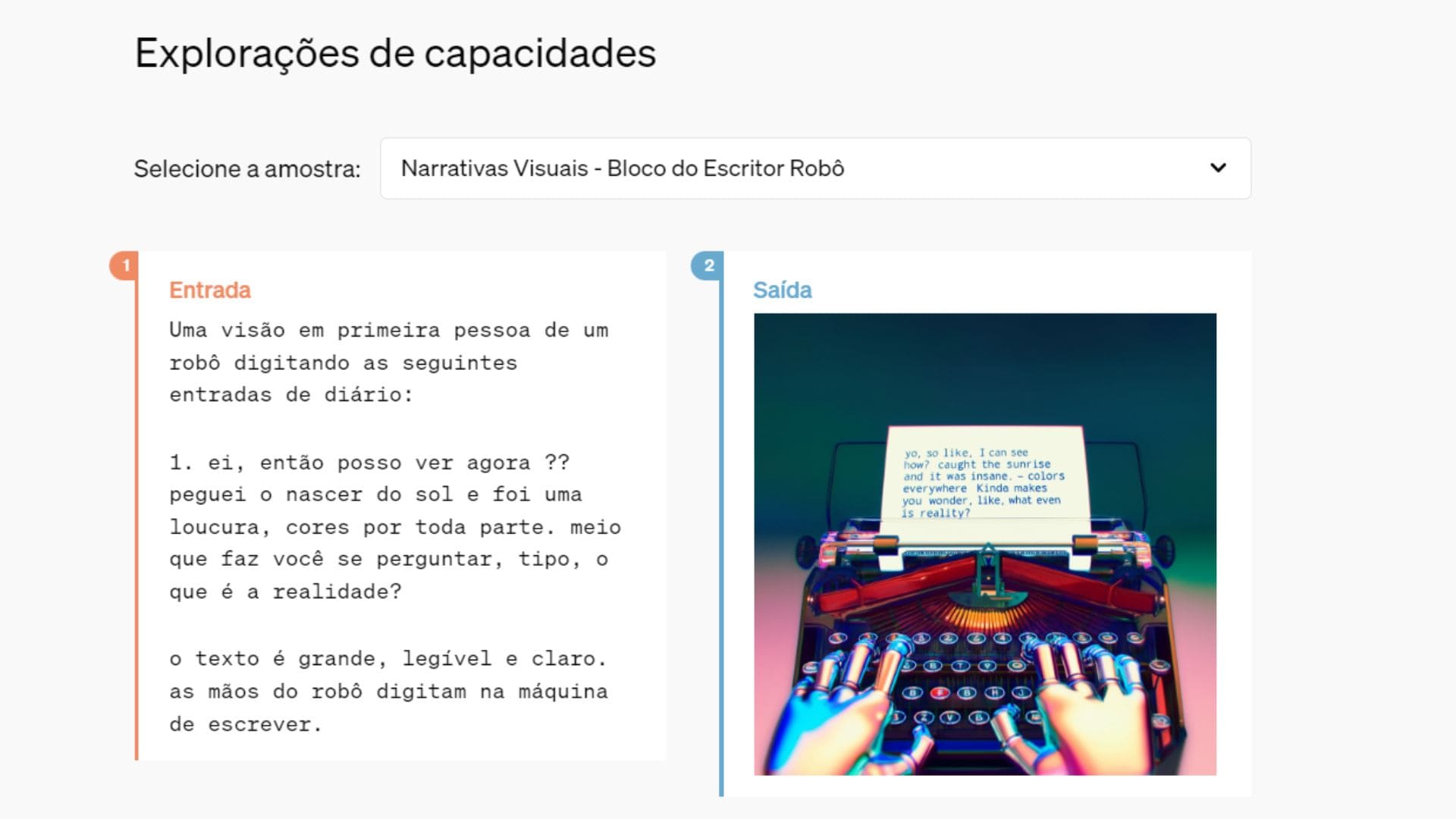

“Ele aceita como entrada qualquer combinação de texto, áudio e imagem e gera qualquer combinação de saídas de texto, áudio e imagem. Ele pode responder a entradas de áudio em apenas 232 milissegundos, com uma média de 320 milissegundos, o que é semelhante ao tempo de resposta humano(abre em uma nova janela)em uma conversa.”

Ou seja, o novo modelo é capaz de corresponder ao desempenho aprimorado do GPT-4 Turbo, mas com uma melhoria significativa na fala e no entendimento de diferentes idiomas, o que oferece um novo meio de comunicação totalmente novo e extremamente eficiente.

“O GPT-4o é especialmente melhor na compreensão de visão e áudio em comparação com os modelos existentes.”

O que mudou do GPT-4 para o GPT-4o?

Segundo a OpenAI, a principal mudança apresentada entre os modelos é a capacidade de resposta do GPT-4o.

“Antes do GPT-4o, você podia usar o modo de voz para falar com o ChatGPT com latências de 2,8 segundos (GPT-3,5) e 5,4 segundos (GPT-4) em média. Para conseguir isso, o Modo de Voz é um pipeline de três modelos separados: um modelo simples transcreve áudio em texto, GPT-3.5 ou GPT-4 recebe texto e gera texto, e um terceiro modelo simples converte esse texto de volta em áudio. Este processo significa que a principal fonte de inteligência, GPT-4, perde muitas informações – não consegue observar diretamente o tom, vários alto-falantes ou ruídos de fundo, e não consegue produzir risadas, cantar ou expressar emoções.”

Basicamente, a startup explica que o GPT-4 precisava de um processo muito mais “longo” para conseguir processar as informações em áudio, uma vez que era preciso que o modelo transcrevesse o que havia sido dito e, em seguida, retornasse a resposta em texto.

Com o GPT-4o, todas as formas de entrada e saída de informação são conectadas e processadas na mesma rede neural, o que diminui o tempo de processamento da informação e facilita o processo.

Quem pode usar o GPT-4o?

O GPT-4o está sendo disponibilizado interativamente a partir do dia 13 de maio, começando pelos recursos de texto e imagem, que estão sendo disponibilizados gratuitamente para usuários das versões Plus e Enterprise do ChatGPT.

Além disso, será lançada uma nova versão do Modo de Voz com GPT-4o em alfa no ChatGPT Plus nas próximas semanas.

“GPT-4o é o nosso mais recente passo para ultrapassar os limites do aprendizado profundo, desta vez na direção da usabilidade prática. Nos esforçamos muito nos últimos dois anos trabalhando em melhorias de eficiência em todas as camadas da pilha.”

Acompanhe todas as atualizações sobre o ChatGPT

Desde o seu lançamento, em novembro de 2022, o ChatGPT vem crescendo e se tornou a ferramenta de IA generativa mais utilizada no mundo.

Acompanhe todas as atualizações sobre essa ferramenta poderosa da OpenAI e descubra como utilizá-la em diferentes funcionalidades no dia a dia acompanhando nosso artigo completo: ChatGPT – O Guia Definitivo.