{+}Olá Assinantes da Agência Mestre,

Recentemente estávamos trabalhando em um projeto de SEO para um cliente onde a etapa era reescrever as URLs para produzir algo amigável para os mecanismos de busca. Pois bem, esta tarefa não é trivial, uma vez que ao reescrever as URLs implica em um grande esforço dos programadores do website, assim como um grande problema para os mecanismos de busca. Vamos entender um pouco mais como funciona para os mecanismos de busca.

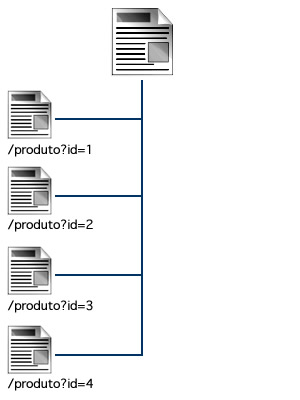

Suponha que a estrutura do seu website seja a seguinte:

E como você já leu aqui na Agência Mestre sobre a importância das URLs amigáveis, você sugeriu a mudança das páginas cheias de parâmetros para algo mais “legível” aos mecanismos de busca, ou seja, URLs com palavras e não apenas números e parâmetros:

Agora, entenda o seguinte, você mudou toda a sua estrutura interna das URLs do seu site, mas você ainda possui os backlinks apontando para a estrutura antiga, ou seja, todo o juice ainda é direcionado ao modelo antigo de URLs. Ao visitar o seu website, os robôs de busca identificam uma nova estrutura de URLs e iniciam a indexação de todas, como se fossem páginas novas. Mas aí é que começa o seu problema: elas não são páginas novas, mas sim as páginas antigas com uma nova URL.

A melhor forma é se pudéssemos avisar os mecanismos de busca que você trocou as URLs, pedindo a ele uma maior agilidade na hora revisitar as URLs antigas a fim de determinar que elas trocaram de caminho. Pois bem, é possível fazer isto com o uso do Sitemap.XML.

Para esta tarefa, crie um Sitemap.XML com as duas versões de URL de cada página. As URLs antigas devem estar com o atributo lastmod marcadas com a data atual, o changefreq em always e a prioridade em 1.0. Já as URLs novas deixe normalmente como seriam. Esta alteração praticamente diz aos Search Engines “revisite rapidamente estas páginas com alta prioridade”, deixando-os acreditar que estas são as suas páginas mais importantes e que o conteúdo delas é super atualizado.

http://www.exemplo.com.br/produto?id=1

DIA ATUAL

always

1.0

http://www.exemplo.com.br/bicicletas

DIA DA ÚLTIMA ALTERAÇÃO

weekly

0.6

Assim os mecanismos de busca visitarão as suas páginas rapidamente, identificando o redirecionamento 301 para a nova URL amigável. Assim que você identificar que eles já indexaram as novas URLs e não haja mais o problema da URL antiga e da nova, retire a antiga versão do seu Sitemap.XML.

Espero que tenham gostado deste artigo e até o próximo.

Gostei bastante dessa dica. Fiz uma alteração de todas as URLs do meu site para URLs amigáveis, e mesmo depois de 2 semanas ainda se podia encontrar as URLs antigas nas buscas do google, juntamente com as novas.

A criação de outro sitemap com as URLs antigas como mostra esse artigo então teria ajudado bastante em agilizar esse processo de mudança de URLs…

Vou fazer o mesmo processo de alteração, mas agora para um cliente. Esse artigo veio a calhar =)